1. L’Intelligenza artificiale sollecita molte questioni di interesse per la scienza giuridica: non è un caso che gli stessi temi si ritrovino nei principali documenti internazionali, come il Report dell’Agenzia per i diritti fondamentali dell’Unione europea (FRA) del 2021 e la più recente Convenzione Consiglio d’Europa 2024 su Intelligenza artificiale, diritti umani, democrazia e stato di diritto.

Variamente declinati, in entrambi i documenti si possono ritrovare quei confini etici e giuridici di maggior attenzione, come il principio di non discriminazione nei riguardi dei lavoratori e delle lavoratrici, con riferimento al genere e all’origine biogeografica e a protezione dei soggetti disabili e delle persone minori; la tutela della dignità e dell’autonomia individuale; i principi dello stato di diritto e tutela della democrazie; il rispetto dei diritti umani e anche nel quadro del diritto internazionale; le garanzie accesso alla giustizia; la necessaria predisposizione di sistemi di valutazioni di impatto e di modelli di supervisione e di controllo.

Le applicazioni dell’Intelligenza artificiale, nella loro significativa variabilità, interessano dispositivi di identificazione biometrica, in delicato bilanciamento fra tutele della riservatezza, sicurezza e ordine pubblico; modelli di categorizzazioni biometriche per etnia, religione, genere, orientamento sessuale, ad esempio mediante trattamenti massivi di dati personali e evidenziando i rischi di derive razziste, abiliste, ageiste...; strumenti di polizia predittiva, che consentono il tracciamento di luoghi, la catalogazione di condotte pregresse, con il pericolo di usi impropri di sistemi repressivi; e ancora bubble filters commerciali, che già permettono la profilazione consumeristica, ma anche e politici, con il rischio di influenzare masse consistenti di popolazione ai fini elettorali e politici.

Insieme agli aspetti richiamati, non si può negare, si pone però la dimensione digitale dell’Intelligenza artificiale, con il carattere volatile, impalpabile, etereo delle condotte; con quei suoi peculiari modelli di circolazione delle informazioni, unitamente alla tradizionale complessità di governo e di controllo sulle stesse informazioni e sui dati.

La tecnica si è fatta digitale.

Il tema del macchinico, della tecnica è molto risalente e insiste a diverso titolo sull’esperienza umana: sull’elaborazione di calcoli complessi, sui modelli organizzativi e del lavoro, sulle scelte e sull’influenza delle scelte contrattuali; sulla salute e sulla procreazione. All’inizio nondimeno era (più che altro) la velocità. Era la risoluzione della complessità, principalmente di calcolo, poi di problemi più complessi: questa era l’informatica alle sue origini, con l’avvento dell’elaboratore di calcolo.

Quindi sembrerebbe un tema antico e per certi versi lo è: forse si potrebbe dire da sempre, l’umano si è proteso a potenziare la propria vita, migliorando prestazioni e finanche sostituendo se stesso se conveniente ovvero simulando la mente. Sono probabilmente connaturati nella storia dell’umanità l’esercizio e la strategia del potenziamento umano, dell’aiuto esterno, della sostituzione.

Così, per centinaia di migliaia di anni, nelle diverse epoche storiche, il tema del rapporto fra umano-tecnica ha accompagnato le riflessioni di grandi pensatori e pensatrici.

Quali sono però le differenze, quale la lacerazione simbolica dell’Intelligenza artificiale con la tecnica, nella sua dimensione risalente, ma anche con l’informatica?

La questione se si vuole simbolica sta lì: nell’intelligenza e nella sua artificialità, ovvero nel mito del funzionamento della mente umana e nell’aspirazione verso la possibilità di replicarne gli stili di funzionamento, la capacità di gestione della complessità e soprattutto gli esiti decisionali. Questa tecnologia, diversamente o più spiccatamente delle precedenti, ha l’attitudine o l’aspirazione di reinventare la natura, l’ambizione di stabilire un’altra narrazione antropologia, chiedendo evidentemente qualche sforzo intellettuale ulteriore.

L’assunto starebbe quindi nell’idea che le nuove tecnologie artificiali siano in grado di riprodurre i meccanismi intellettuali del pensiero umano (e di qui, il passo potrebbe essere breve, dell’inconscio umano).

In tale prospettiva, le riflessioni che oggi albergano il tema del rapporto fra umano e tecnica si rivolgono a quello che è stato individuato come un passaggio fondamentale, di non ritorno: dalla tecnica funzionale (che è strumento) alla tecnica teleologica (che si dà come scopo) che, avendo però l’ambizione di reinventare la natura, potrebbe - si teme possa avere - anche la capacità di pensare e costruire un proprio mondo, una propria antropologia. Quindi di essere scopo di sé: e ciò rende la riflessione più complessa.

È in questo contesto che la scienza giuridica (non da sola, si può auspicare) è chiamata a individuare cornici di senso per la coesistenza - plausibile e possibilmente duratura - fra umano e macchinico; ovvero, per dirlo con una maggiore consistenza giuridica, a rispondere all’ineluttabile esigenza di tenere insieme l’inarrestabile avanzare dell’Intelligenza artificiale con principi irrinunciabili dell’umanesimo giuridico, bilanciando cautela e fiducia, prudenza e visione.

2. Ricondotto questo tema sul piano del diritto, dell’argomentazione giuridica, della costruzione della decisione, tutto appare di notevole significanza, per essere il mondo giuridico un interessante banco di prova su più livelli: strutturale, etico, politico.

Affrontando la questione su un piano strutturale, quello del mondo giudiziale che si rivolge all’Intelligenza artificiale, le questioni appaiono per certi versi più agili e rimandano a quei dispositivi di legal assistant o prompting, destinati tendenzialmente a tutte le professioni giuridiche, e che si orientano a favore della predeterminazione delle strategie difensive, della prevedibilità delle decisioni, dell’introduzione di modelli matematici di calcolo.

Sono strumenti che certamente aumentano la velocità operative: lo fanno, in particolar modo, per quei segmenti routinari del lavoro, che si presentano analiticamente più semplici e ripetitivi. Sono strumenti che costruiscono esiti o prodotti sulla base di informazioni predate: si pensi al caso delle liti temerarie o delle clausole vessatorie. Sono esperienze che appaiono affascinanti, anche se sembra si adattino meglio - o forse nascono pensati come maggiormente affini - ai modelli ordinamentali di common law o, ancora, più adeguati ad alcuni settori del diritto più che ad altri: la sensazione è che per alcuni degli strumenti di Intelligenza artificiale, la dimensione romanistica, quella del giurista continentale, e sicuramente la postura accademica fatichino ad assecondare logiche di facilitazione del pensiero.

Al netto di alcune sommarie notazioni, nondimeno, appare certamente affascinante pensare che la raffinatezza degli esiti possa essere illimitata, perché collegata ad un quantum di “immagazzinabilità” delle informazioni, che potrebbe, in tal senso, essere sconfinata e, soprattutto, gestibile.

Un altro elemento, sicuramente affascinante, può essere introdotto usando una definizione offerta dal “Gruppo di esperti ad alto livello sull’Intelligenza artificiale”, istituito dalla Commissione Europea, circa gli Orientamenti etici per un’IA affidabile, pubblicato nel 2018. Il documento intende garantire l’affidabilità dell’Intelligenza artificiale come prerequisito per il suo sviluppo ed utilizzo, in relazione alle qualità tecnologiche e al contesto sociotecnico, ovvero ai processi e agli attori che utilizzano le applicazioni di Intelligenza artificiale.

Il Gruppo esperti definisce l’Intelligenza artificiale come tutti quei sistemi software (ed eventualmente di hardware) progettati dall’uomo, che agiscono nella dimensione fisica o digitale percependo il proprio ambiente attraverso l’acquisizione di dati, interpretando quei dati strutturati o non strutturati, ragionando sulle conoscenze o elaborando le informazioni derivate e decidendo le migliori azioni da intraprendere per raggiungere un certo obiettivo.

I sistemi di Intelligenza artificiale possono usare regole simboliche o apprendere un modello numerico e possono anche adattare il loro comportamento, analizzando in che modo l’ambiente sia influenzato dalle loro azioni precedenti.

Da tutti questi elementi, l’Intelligenza artificiale impara per progredire. Detto aspetto, ovvero quello della capacità di imparare, appare in effetti una funzione straordinaria.

Proprio questo, fra i molti, è certamente l’aspetto sfidante, anche collocato all’interno del sistema giuridico. E lo sarebbe ancor di più, sfidante, se il diritto fosse una scienza esatta, immaginata come replicabile infinitesimamente nella triade fatto, regola applicazione.

Pur tuttavia, per rappresentare la questione con le parole di Hobbes, il diritto non è potere, semmai è la ricerca della giustizia nella regola: il principio si materializza nel fatto concreto e in quello stesso principio il fatto trova la sua attuazione e contenimento. Ma il fatto non è mai ripetitivo: il fatto concreto non sopporta un modello di prevedibilità, se non forse nella dimensione più semplicistica, o nella struttura procedurale, o ancora in alcuni elementi che si rinvengono ricorrenti.

O forse il modello di prevedibilità è piuttosto in grado di rispondere ad un bias di controllo non necessariamente conferente con le evidenze.

“Nella realtà ci sono molte più cose di quante ne possa contenere una regola”, afferma Greco[1]. Così la funzione del giurista resterà autorevole nella misura in cui egli o ella sappia interpretare un compito diverso; nella misura in cui egli o ella sappia sostenere una struttura argomentativa che tenga insieme riflessione, fantasia, audacia; sensibilità, volontà e ragione. Mentre le macchine, per quanto intelligenti, per quanto capaci di imparare, fanno pur sempre uso di una raccolta ingente di dati, di modelli quantitativi, di connessioni logiche e di modelli statistici del linguaggio.

Ma tutto questo, per quanto sfidante, non ha a che vedere con l’intenzione, con la dimensione dell’io interiore, che è inaccessibile alla potenza del pensiero oggettivante della funzione matematica. Tutto questo non ha a che vedere con l’empatia, con la relazione. Dice Byung Chul Han che “il pensiero resta un processo analogico”[2]: il mondo lo commuove, lo tocca. La prima immagine del pensiero è la pelle d’oca. Perché il pensiero scaturisce da un tutto, origina da campo di esperienza, da un orizzonte semantico. Il pensiero ascolta, origlia, tende l’orecchio. Suggerisce. Tentenna. Il pensiero ha il dubbio. L’Intelligenza artificiale ha un buon udito, ma non vacilla: ascolta i fatti predati, le connessioni inculcate, le probabilità statistiche fra A e B.

Mentre il pensiero è C: il pensiero è l’altrove.

3. Semmai ci sono altri due aspetti degni di riflessione: un piano etico e uno politico connessi all’intelligenza artificiale nel sistema giuridico e nel mondo delle professioni legali, ma se si vuole nella dimensione delle professioni intellettuali.

C’è un piano etico, nello specifico di etica del lavoro, dello studio e della ricerca, non solo nei termini abusivi delle condotte - che non per nulla interessano il campo del diritto del lavoro[3], del diritto antidiscriminatorio e delle pratiche che producono vulnerabilità.

C’è invece un tema più strettamente intellettuale in termini di potenziale impoverimento del pensiero e che coinvolge lo studio sui libri, la scrittura di una tesi, e poi di articoli scientifici, di sentenze, di atti difensivi: se prenderemo a produrre studi, ricerche, provvedimenti con l’Intelligenza artificiale, cosa resterà di noi? Perché se forse è vero che di noi resterà ancora molto, vi è piuttosto da chiedersi che cosa resterà di quelli e di quelle che verranno dopo di noi. Perché di quelle persone, del loro destino - educativo, formativo, professionale - forse dovremmo assumerci una responsabilità condivisa.

È molto ben evidente come opera l’Intelligenza artificiale nel campo delle professioni, dato per accolto quanto detto in premessa: l’esercizio e la strategia del potenziamento umano, dell’aiuto esterno, della sostituzione sono connaturati alla storia dell’umanità.

La fascinazione ulteriore è che, forse in maniera e più efficace di altre tecnologie meccaniche - ma similmente al mondo di Internet, l’Intelligenza artificiale è un inganno della mente: apparentemente essa è democratica; salta intermediazioni di potere che ostacolano il raggiungimento del risultato; smaltisce la fatica, scaccia i crucci; velocizza, supera, ottimizza il presente, elimina la paura del futuro.

Proprio questa riflessione conduce ad un altro piano del discorso, quello politico.

Se si guarda, infatti, la questione dell’Intelligenza artificiale su un livello più profondo, ontologico, allora la riflessione si fa, ad avviso di chi scrive, ancora più complessa: perché qualsiasi tecnologia non è mai neutra e questa forse rappresenta il tema in termini ancora maggiori, per la sua evanescenza, per la difficile controllabilità, per la speditezza e per la forza economica che spinge e da cui è spinta e promossa.

C’è a ben vedere una sorta di narrazione sottesa che sta a mezzo fra l’oscurantismo e l’accoglienza, quella della neutralità degli strumenti di cui si parla: una narrazione che rimanda all’idea che le qualità negative o positive dell’Intelligenza artificiale dipendano da come la si usa; da quali limiti giuridici si porranno, da quali limiti apporre e da quale bilanciamento trovare fra etica, diritto e mercato.

Così si pone il regolamento Ue n. 2024/1689, sull’Intelligenza artificiale (AI Act): per promuovere un’Intelligenza artificiale che sia affidabile, esso garantisce che i sistemi siano sviluppati e utilizzati in modo responsabile: il regolamento introduce una disciplina che prevede una scala dei rischi, e quello del rischio inaccettabile, inibendo così l’utilizzo e l’immissione nel mercato di sistemi di Intelligenza artificiale ritenuti potenzialmente lesivi dei diritti fondamentali delle persone; così per quelle tecniche subliminali che possono condizionare il comportamento o le scelte delle persone; quelle che sfruttano le vulnerabilità di una categoria di persone per loro età, disabilità, condizione sociale, genere..; quei sistemi per la valutazione o la classificazione dell’affidabilità delle persone in base al loro comportamento sociale o alle loro caratteristiche (social scoring); e quelli che utilizzano tecniche di identificazione biometrica remota “in tempo reale” in spazi accessibili al pubblico.

Mediante il modello della regolamentazione dei rischi accettabili, invero, l’Ue cerca di contenere gli spazi importanti di rischio, al contempo ponendosi in un difficile equilibrio con l’approccio e il potere statunitense, che di certo non promuove forme regolatorie di tipo precauzionale, quanto piuttosto l’innovazione e il mercato e la sua stessa leadership. Nella consapevolezza della complessità del tema all’interno del sistema globale dei poteri, va però rammentata anche la questione più autenticamente politica: così l’Intelligenza artificiale, oltre ad essere un paradigma che obbliga ridiscutere il posizionamento dell’umano, che impone uno sguardo da fuori, è anche un’industria, quindi una forma di esercizio del potere. Come tale, mai neutro.

“Non possiamo veramente esperire il nostro rapporto con l’essenza della tecnica finché ci limitiamo a rappresentarci la tecnicità e a praticarla, a rassegnarci ad essa o a fuggirla. Restiamo sempre prigionieri della tecnica e incatenati ad essa, sia che la accettiamo con entusiasmo, sia che la neghiamo con veemenza. Ma siamo ancora più gravemente in suo potere quando la consideriamo qualcosa di neutrale; infatti, questa rappresentazione, che oggi si tende ad accettare con particolare favore, ci rende completamente ciechi di fronte all’essenza della tecnica”, argomentava Heidegger nel celebre discorso su La questione della tecnica[4] già agli inizi degli anni Cinquanta, rappresentando il tema della neutralità con limpidezza e attualità.

4. Come si gestisce quindi l’Intelligenza artificiale? E come si governa un mondo in cui il digitale ha ormai un ruolo ineludibile? Il digitale derealizza, disincarna il mondo: è come se il mondo si stesse svuotando delle cose, riducendosi a una forma incorporea. È come se le non-cose stessero penetrando nella nostra vita, scacciano le cose: quelle cose del mondo, diceva Arendt, che hanno il compito di stabilizzare la vita umana[5].

Così quell’ordine umano, costituito da cose che assumono una forma durevole e che danno luogo ad un ambiente stabile, sembra sostituito da non-cose[6]: non più beni ma servizi; non più cose informazioni; non più proprietari, ma consumatori; non più realtà ma social. Abbiamo smesso di vivere il reale. Abbiamo abdicato l’umano, abbiamo dimenticato le cose.

E come si governa un mondo disincarnato, dematerializzato?

L’ordine giuridico ci pone di fronte tradizionalmente alla necessità di trovare risposte rispetto ai contenimenti dell’umano, alla dimensione del limite per governare la complessità. Pur nella grande fiducia nel pensiero giuridico, la risposta sui limiti non potrà essere solamente una risposta giuridica, quanto meno non nel suo senso più tradizionale.

La risposta al richiamo di governare una materia così complessa, non può arrivare solo da regole formali discese dall’alto, ma deve emergere anche attraverso dinamiche virtuose di autoregolamentazione, poiché “non si dà controllo senza autocontrollo, cioè senza quella disposizione alla ‘padronanza di se stessi’ che costituisce il motore d’ogni ordinamento, sia esso politico, giuridico od economico”[7].

Nondimeno, la forza contenitiva, simbolica e promozionale del diritto può certamente rispondere ad alcuni degli appelli che il digitale pone.

Al pari della libertà, matrice giusnaturalistica dei diritti, noi sappiamo che il limite è connaturato nell’essenza del diritto: ma non nel senso più semplicistico, del divieto, della sanzione, della procedura; bensì in quello più radicalmente solidaristico, quello della responsabilità individuale, collettiva, verso noi stessi e quindi verso i pari, ma ancora di più verso le generazioni future: la dignità, la solidarietà, la responsabilità, sono in queste cifre che troviamo il senso dell’umano.

È nella fiducia, che continuiamo a riporre nel diritto[8], forse la chiave della risposta alla complessità: rammentarci della fiducia che il diritto ci accorda, forse significa anche rammentarci della responsabilità che il diritto ci affida. Ed è nel gioco delle reciproche aspettative relazionali che il diritto innesca, circolari e dinamiche, che dovremo continuare a cercare (e poi trovare) un dose consistente di fiducia.

[1] Tommaso Greco, La legge della fiducia, ed. Laterza, 2021.

[2] Byung Chul Han, Le non cose, Einaudi, 2023.

[3] Marco Peruzzi, Intelligenza artificiale e lavoro, Giappichelli, 2023.

[4] Martin Heidegger, La questione della tecnica. Con un saggio di Federico Sollazzo, GoWare, 2017.

[5] Hanna Arendt, Vita activa. La condizione umana, Bompiani, 2017.

[6] Byung Chul Han, Le non cose, Einaudi, 2023, cit.

[7] Francesco Gentile, Politica aut/et statistica, Giuffrè, 2003.

[8] Tommaso Greco, La legge della fiducia, ed. Laterza, 2021, cit.

Riflessioni a margine del Convegno “Diritti e tutele nell’era dell’Intelligenza artificiale” (XXI Convegno Cammino, Università Cà Foscari di Venezia 14-15 marzo 2025).

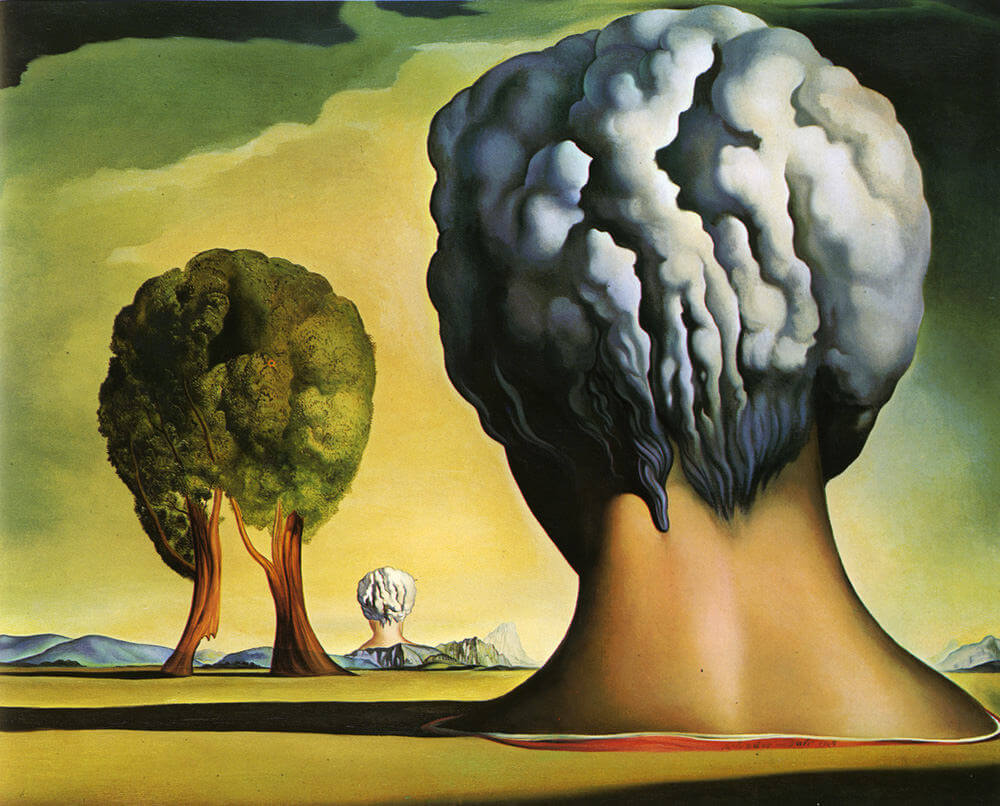

Immagine: Salvador Dalì, Le tre sfingi di Bikini, 1947.

E poi Aggiungi alla schermata principale.

E poi Aggiungi alla schermata principale.