Sommario: 1. Spigolature sul tema - 2. Scienza matematica e scientia giuridica. Prove di dialogo - 2.1. AI e verità - 3. Formazione del giurista nell’era dell’intelligenza artificiale. Un nuovo alfabeto fra contenuti innovativi e modelli di formazione giudiziaria - 4. La formazione del giurista nell’era dell’intelligenza artificiale - 4.1. L’albero della formazione dei magistrati in tema di AI: a) che cosa dovrebbe sapere un giurista? - 4.2. Segue: b) con chi dovrebbe essere formato? - 5. Conclusioni (in progress).

1. Spigolature sul tema

Nel cuore del dibattito contemporaneo sull’intelligenza artificiale si colloca un interrogativo cruciale: può l’IA sostituire o replicare il giudizio umano all’interno del sistema giustizia? Ed ancora, quale posto può occupare l’AI senza alterarne l’equilibrio costituzionale, etico ed epistemologico?

Nel panorama di queste domande, sempre più incalzanti tanto quanto lo sono le risposte da più parti proposte, si collocano, da angolazioni diverse ma sorprendentemente convergenti, studiosi di campi apparentemente distanti: matematici, costituzionalisti, comparatisti, magistrati.

Impossibile, ovviamente, dare conto di tutte le opinioni in campo ed invece “umanamente possibile” provare a selezionare, sulla base di scelte valutative “umane” e non basate sulla logica algoritmica, alcune voci dotate di un grado di persuasività e comprensibilità tali da consentire una riflessione, peraltro, assolutamente aperta e ben lontana dall’essere risolutiva e conclusa.

Assai utile, dunque, partire da un portatore di saperi altri che il giurista, oggi più che mai, sente il bisogno di coinvolgere in quanto portatore di conoscenze che sarà “costretto” a maneggiare con cura e attenzione.

Il matematico Alfio Quarteroni, nel corso di uno degli incontri programmati dalla SSM con i MOT di Accademici dei Lincei, forte di una lunga esperienza nel calcolo scientifico e nella modellazione, ha delineato la distinzione tra algoritmi deterministici — tipici della tradizione matematica classica — e algoritmi adattivi, che caratterizzano l’IA moderna. Questi ultimi non seguono una logica pienamente prevedibile e non sono governati da istruzioni trasparenti, ma si sviluppano per correlazione statistica e addestramento empirico.

Eppure, osserva Quarteroni, per quanto l’IA possa emulare il linguaggio umano, essa non possiede alcuna consapevolezza, intenzionalità o senso del valore. È, in altri termini, una potenza senza coscienza: può suggerire, accelerare, ordinare; non può comprendere né decidere in senso etico o giuridico.

Il professor Quarteroni sostiene però che l’intelligenza artificiale possa rafforzare la scienza tradizionale, fondata su teoria, esperimento e simulazione, senza sostituirla. Questo approccio, chiamato scientific machine learning valorizza l’apprendimento dai dati all’interno di cornici teoriche ed “umane” consolidate.

Traslando questa idea al campo del diritto, il matematico propone una via intermedia tra una fiducia ingenua nell’efficienza dell’IA e un rifiuto rigido, legato alla sua mancanza di umanità.

In definitiva, una proposta di integrazione costruttiva in cui la scienza del diritto fornisce la cornice normativa entro cui l’IA dovrebbe operare, vincolata da principi, valori e logiche argomentative. Gli algoritmi giuridici possono aiutare a organizzare precedenti, individuare pattern o simulare scenari, ma non devono sostituire il giudizio umano, che rimane centrale. Il giurista ha così un ruolo fondamentale come interprete consapevole, capace di comprendere la logica algoritmica senza smarrire la profondità del sapere giuridico. In questo modo il diritto non diventa – e non può diventare - automatico, ma aumenta la sua capacità di essere sagomato ai bisogni, tarato sulle necessità, completo nei suoi percorsi decisionali. In una parola, più informato ed efficace, senza tuttavia perdere la sua dimensione umana.

Questo rilievo, proveniente da uno “scienziato non giurista” sembra trovare sponda nelle riflessioni giuridiche più avvertite sul ruolo dell’IA nel diritto.

Luciano Violante[1], affrontando il tema delle sfide democratiche della digitalizzazione, ha più volte ragionato sul rischio di una “società della scatola nera”, in cui le decisioni algoritmiche sfuggono al controllo democratico e rendono opachi i criteri di imputazione e responsabilità. Per contrastare questa deriva Violante propone di trasformare le “black box” in “glass box”. La digitalizzazione non è paragonabile alle precedenti rivoluzioni tecnologiche, entrando nel cuore della coscienza collettiva e così modificando la formazione delle opinioni, i processi cognitivi e perfino le relazioni sociali. La metafora della black box descrive dunque il pericolo di un potere algoritmico opaco: «through machine learning, data matching and automatic profiling, black boxes process large amounts of information, understand text, recognize images and connect the dots». Tali sistemi non sono neutri, poiché «an algorithm designer conveys his beliefs in the algorithm he creates, and so his beliefs become reality». In questo senso, la scatola nera rappresenta non solo l’incomprensibilità tecnica dell’algoritmo, ma anche la sua capacità di trasmettere, senza trasparenza, i pregiudizi e le visioni del mondo di chi l’ha costruito. Il rischio concreto è dunque che decisioni fondamentali per i diritti delle persone vengano prese sulla base di processi non verificabili, sottratti al controllo democratico e alla possibilità di contestazione. Per questo si afferma la necessità di passare dalle black boxes alle glass boxes, affinché «algorithmic decision-making needs to be fully transparent and individuals should have the right to challenge decisions made by an algorithm». La trasparenza diventa quindi una condizione essenziale per preservare la dignità dell’uomo e il ruolo del diritto: solo se gli algoritmi sono spiegabili e accessibili, l’individuo può rivendicare i propri diritti e la giurisdizione può esercitare il suo controllo. Da qui la sfida alla quale sono chiamati gli “umanisti”, volta a difendere la centralità dell’essere umano rispetto alla macchina, riaffermare il primato della responsabilità e del giudizio, garantire che l’uso dell’intelligenza artificiale sia sempre accompagnato da «transparent criteria in algorithmic design, digital education, the protection of the freedom to decide for oneself». La “black box” diventa così la metafora del pericolo maggiore della società digitale: l’oscurità decisionale che priva l’individuo della sua capacità di comprendere e di scegliere, e che rende urgente una nuova alfabetizzazione digitale e un quadro di regole volto a restituire all’uomo il dominio sulla tecnologia.

Da quell’immagine occorre allontanarsi, trasformandola in una scatola di vetro riempita di sistemi trasparenti ed auditabili. Terminologia, quest’ultima, assolutamente nuova per un giurista ma capace di rendere chiara l’esigenza di conoscere in quale modo l’algoritmo giunge ad una conclusione, quali dati utilizza e quali scarta e quali meccanismi di controllo offre rispetto alle soluzioni dispensate e mantenute in una cornice di legalità costituzionale.

In un ulteriore contributo[2] è sempre Violante a delineare con chiarezza la centralità del giudice come presidio di responsabilità e di garanzia costituzionale di fronte all’irrompere dell’intelligenza artificiale nei processi decisionali. L’autore sottolinea che “nessuna decisione che riguardi l’essere umano può essere presa in via definitiva dalla IA”, affermando un principio che delimita lo spazio dell’algoritmo e riafferma l’irrinunciabile competenza dell’autorità giudiziaria. La decisione, infatti, non è mera applicazione di regole tecniche, ma assunzione di responsabilità nei confronti delle conseguenze che essa produce. Per questo Violante richiama l’idea che “a chi cagiona dolore non dev’essere garantita la neutralità rispetto alle conseguenze della sua scelta. È un principio che appartiene all’umano prima che al giuridico o al tecnologico”, rimarcando come la funzione giudiziaria non possa essere delegata ad apparati privi di coscienza morale. L’IA, inoltre, trasforma i processi cognitivi e i circuiti del pensiero giuridico, perché “la formazione del pensiero si modifica” e la cultura dovrà imparare a “utilizzare in questa direzione gli strumenti digitali, anche nella nuova forma delle concatenazioni del pensiero”. Il compito del giudice diviene allora duplice: da un lato, saper usare le potenzialità del digitale come strumento di conoscenza; dall’altro, preservare la trasparenza e la legittimazione democratica delle decisioni, in quanto “il potere in democrazia dev’essere moralmente accettabile e non può essere invisibile. Un potere opaco non è moralmente accettabile”. In definitiva, il giudice si conferma custode della dignità della persona e garante dei diritti fondamentali, assicurando che la “Civiltà Digitale” resti, come afferma Violante, “una condizione umana caratterizzata dal dominio dell’uomo sulla tecnica digitale” e non il contrario.

In sintonia con le riflessioni di Violante, Oreste Pollicino[3] ha parlato ripetutamente di costituzionalismo digitale e del rischio che il potere computazionale, se non costituzionalizzato, rischierebbe di diventare un “Leviatano tecnocratico”[4], in cui la regola si dissolve nel comando, e il diritto perde la sua funzione deliberativa. Pollicino, forte della matrice costituzionale dei suoi studi e delle influenze prodotte da uno dei suo Maestri- Antonio Ruggeri – non poteva che porre al centro della riflessione la tenuta dei canoni costituzionali- fra i quali quello che lo riassume può forse indentificarsi con il personalismo – rispetto all’avvento dell’algoritmo e dell’IA. La digitalizzazione e l’IA che la prima preannuncia, secondo Violante e Pollicino sollevano dunque nuove questioni in materia di diritti umani, come la protezione della privacy, la libertà di espressione e il diritto all'informazione ed il rischio della disinformazione, oltre a quello della discriminazione algoritmica[5].

Il rischio riguarda dunque anche la salvaguardia della rule of law, oggi sottoposto a una pressione senza precedenti, visto che le grandi piattaforme digitali, pur essendo soggetti privati, esercitano di fatto funzioni pubbliche — dalla moderazione dell’informazione alla definizione delle libertà d’espressione. Queste piattaforme non rispondono affatto a logiche democratiche ma algoritmiche ed espressione così di chi le ha raccolte oltreché spesso opache[6]. È dunque cruciale garantire che i diritti fondamentali siano rispettati anche nel contesto digitale, attraverso una combinazione di regolamentazione normativa, educazione e responsabilità delle aziende tecnologiche.

All’analisi degli studiosi appena ricordati[7] si affianca quella di Andrea Simoncini, anch’essa centrata sul rapporto tra intelligenza artificiale e diritto costituzionale[8]. L'IA non rappresenterebbe solo una questione tecnica o normativa, ma una vera e propria trasformazione antropologica capace di incidere profondamente sull'architettura costituzionale. Afferma Simoncini che “Quando la decisione va ad incidere su posizioni giuridiche soggettive non potrà mai (dunque, neppure nel caso di amministrazione vincolata) essere sostituita tout court da un algoritmo, perché una decisione del genere non consentirebbe l’esercizio del più elementare diritto che ogni persona ha quando viene toccata dal potere pubblico: comprenderne le ragioni per poterle contestare in punto di fatto e di diritto”[9]. Da qui la necessità di una riflessione profonda su come adattare i principi costituzionali per preservare la dignità e i diritti della persona nell'era digitale, ponendo l’attenzione sul fatto che le potenzialità dell'IA nel migliorare l'efficienza del sistema giudiziario possono recare al loro interno una più o meno avvertita riduzione della discrezionalità e dell'umanità del giudicare.

Proprio l'opacità e la mancanza di accountability degli algoritmi possano minare la trasparenza e la responsabilità, principi fondamentali dello Stato di diritto.

La civilistica italiana non ha mancato di occuparsi del tema. Nel saggio Diritto, algoritmo, predittività[10], Nicolò Lipari mette in guardia dal ricondurre la decisione giudiziale alla mera esecuzione di un algoritmo, ricordando che il diritto contemporaneo è scienza pratica: non discende solo da norme astratte, ma si concreta nel caso, nell’argomentazione e nel bilanciamento di principi – in primis la ragionevolezza e l’eguaglianza sostanziale di cui all’art. 3 Cost. L’algoritmo, pur utile come ausilio (ad esempio per individuare precedenti o incoerenze), incorpora precomprensioni, opera su correlazioni storiche del passato e difetta della valutazione in termini di ragionevolezza che sta, invece, alla base del giudicare. Ragioni, queste, che rendono insostituibile l’apporto del giudice, al quale spetta armonizzare norme, principi e realtà sociale. La predittività potrebbe, secondo Lipari, trovare terreno più favorevole nella giustizia tributaria[11], dove le fattispecie sono spesso seriali e i dati oggettivabili, ma il passaggio dalla tecnica per fattispecie alla tecnica per principi rende impossibile comprimere la decisione nella binarietà del calcolo. In definitiva, l’intelligenza artificiale può contribuire a una giustizia aumentata solo se resta strumento e non soggetto, lasciando al giudice l’ultima parola e preservando la dimensione umana, storica ed emotiva del giudicare.

Anche Giovanni Comandè, parlando di “normatività algoritmica” per descrivere l’effetto pervasivo degli automatismi digitali, porta l’attenzione sul fatto che, se l’algoritmo diventa il filtro attraverso cui passa ogni valutazione di rischio, danno o colpevolezza, vi è un concreto rischio di piegare la funzione giurisdizionale a una logica performativa, al punto che il diritto non produrrebbe più giustizia, ma riproduce pattern. Da qui la necessità, per Comandè, di riaffermare la centralità della “spiegabilità” del diritto (e della giustizia) e della discrezionalità, rinnovando — anche alla luce della trasformazione tecnologica — la stessa architettura della responsabilità civile.

Ecco, ancora una volta, una nuova convergenza fra diversi saperi, quello scientifico matematico e quello della scientia juris.

La spiegabilità algoritmica secondo Comandè costituisce un diritto fondamentale con radici nell’art. 8 CEDU (vita privata) e nell’art. 22 GDPR (divieto di decisioni automatizzate senza supervisione umana significativa) - «Senza spiegabilità, non c’è giustizia. La motivazione algoritmica deve poter essere decodificata, verificata e criticata.»

Comandè sottolinea che ogni sistema decisionale basato su IA dovrebbe essere auditabile, contestabile e trasparente. L’opacità tecnica non può mai giustificare la sottrazione al controllo giuridico/giudiziario. La motivazione algoritmica deve essere sottoposta a standard giuridici, non solo ingegneristici.

Giovanna De Minico, per parte sua[12], muove dalla premessa che il giudice debba restare “indifferente a ordini, direttive o indicazioni, dettati o suggeriti da altri poteri dello Stato” e non può trasformarsi in un mero “rubber stamp” dell’esito algoritmico, poiché il “coinvolgimento umano consiste, non in un semplice gesto simbolico, ma in un controllo significativo” dotato di competenza e autorità per modificare la decisione automatizzata. La motivazione non può ridursi a una tautologia (“l’amministrazione ha deciso così, perché l’algoritmo ha deciso così”), ma deve “spiegare in termini chiari e comprensibili le ragioni per cui ha condiviso il risultato della macchina”. De Minico ammette un ruolo ausiliario dell’IA — “la macchina è un ausilio necessario o utile al giudice?” — nella fase istruttoria e nell’analisi probatoria, ma esclude che essa possa sostituire la decisione, prerogativa insopprimibile dell’uomo. Avverte inoltre che l’algoritmo “può fornire l’illusione di una ‘verità’ oggettiva e neutrale”, ma questa “verità” è “un prodotto dei dati che l’allenano, della loro qualità, completezza e imparzialità”, con il rischio che il giudice la assuma come un “dato certo” anziché come una tesi da verificare e sottoporre a critica. Un ulteriore argomento è di ostacolo all’ingresso nel processo dell’algoritmo decidente: la “riserva di nomofilachia alla Corte di Cassazione”. Questo tipo di algoritmo “comprometterebbe il fair play competitivo rispetto alla Corte Suprema perché la sostituirebbe di fatto nell’interpretazione unitaria del diritto” e, sdoppiando gli attori della nomofilachia, avrebbe un “effetto paralizzante sulla riforma del processo civile del 2006”, che intendeva rafforzare il ruolo uniformante della Cassazione. Ciò conferma, conclude l’autrice, “l’assoluta estraneità dell’intelligenza artificiale alla funzione di nomofilachia”, che deve restare di esclusiva competenza del giudice di ultima istanza.

In parallelo[13], De Minico richiama un analogo “nesso tra potere politico/responsabilità” e indica un’“insuperabile linea di confine” oltre la quale l’IA non deve spingersi, poiché il “policy maker” resta “l’esclusivo titolare del potere di scegliere tra gli interessi pubblici rilevanti”, senza delegare alla macchina la graduazione dei valori o la decisione finale. Anche qui si ammette l’uso dell’IA per “analizzare e sintetizzare i dati” ovvero “offrire scenari alternativi” che il decisore possa valutare, ma si ribadisce che la scelta conclusiva, specie se implica un bilanciamento tra diritti fondamentali, deve restare ancorata alla responsabilità politica e alla consapevolezza umana così come, in ambito giudiziario, la decisione deve restare ancorata alla responsabilità del giudice.

Sul versante amministrativo e senza soluzione di continuità rispetto alle opinioni sinteticamente raccolte, attente al piano costituzionale, si pone quella del Consigliere di Stato Giovanni Gallone.

Il concetto di "riserva di umanità" elaborato da Gallone[14] si riferisce alla necessità di preservare un ambito decisionale esclusivamente umano all'interno delle funzioni amministrative, esistendo limiti etici e giuridici invalicabili che richiedono l'intervento della persona[15], soprattutto quando le decisioni amministrative incidono significativamente sui diritti e sulla dignità delle persone. La "riserva di umanità", agganciata al modello costituzionale sagomato sulla centralità della persona umana,[16] si configura dunque come un principio fondamentale che delimita l'uso dell'automazione nelle decisioni pubbliche, assicurando che la tecnologia rimanga uno strumento al servizio della persona e non un fine in sé.

Un tentativo di unire mondi diversi in una prospettiva di dialogo sta alla base del libro Decidere con l’IA. Intelligenze artificiali e naturali nel diritto, in cui Amedeo Santosuosso e Giovanni Sartori esplorano le implicazioni dell’IA nel contesto giuridico, presentando un panorama che spazia dai sistemi predittivi alle reti neurali fino ai Large Language Models. Ragionando sul volume appena ricordato, Claudio Castelli[17] mette in evidenza come il libro offra una trattazione “ampia e approfondita” del rapporto tra intelligenze artificiali e decisione giuridica, mantenendo un equilibrio tra rigore tecnico e chiarezza espositiva. Castelli sottolinea la distinzione tracciata dagli autori tra decisione “composita” e decisione “complementare”: l’IA “può contribuire al processo decisionale, ne può essere un valido ausilio, ma non è complementare al decisore umano”. Richiama inoltre il nodo della spiegabilità, segnalando che “i sistemi che forniscono le prestazioni più elevate, ovvero le predizioni più accurate, sono più opachi”, con il conseguente rischio di ridurre la trasparenza. Secondo Castelli, Santosuosso e Sartor evidenziano come il ricorso all’IA possa stimolare una riflessione più profonda sull’atto del giudicare, ma ribadiscono che “il centro resta indiscutibilmente l’essere umano”: la formazione del giurista è imprescindibile, perché solo un decisore consapevole può governare l’uso dell’IA senza rinunciare alla propria autonomia critica.

2. Scienza matematica e scientia giuridica. Prove di dialogo

Tornando a Quarteroni, l’autorevole matematico propone dunque un paradigma integrativo dove l’IA, purché a monte caratterizzata dalla “spiegabilità” delle sue conclusioni, diventi un supporto intelligente e non un sostituto, della conoscenza teorica. Nel diritto, ad esempio, l’IA può offrire assistenza nell’analisi di casistica giurisprudenziale o nella previsione di esiti legali, ma non può sostituirsi al giudizio umano, che rimane insostituibile per responsabilità, etica[18] e capacità di spiegazione. La diagnosi di una grave malattia ed i rimedi per fronteggiarla non potranno che essere fatti dal medico, ci dice Quarteroni, ma le sue valutazioni e conclusioni non potranno che svolgersi sulla base di dati, conoscenze e valutazioni che l’IA gli ha fornito e che lo stesso elaborerà, personalizzerà, applicherà al caso concreto con una capacità di successo nell’esito finale grandemente superiore a quella che si sarebbe potuto immaginare “prima”. In questa prospettiva, l’approccio che il Prof. Quarteroni chiama machine learning scientifico – cioè, l’integrazione fra dati e teoria – rappresenta la chiave per una IA al servizio della scienza e della società, e in particolare per un utilizzo giuridicamente sostenibile e trasparente di questi strumenti.

Ho quindi trovato di particolare valore il fatto che il concetto di spiegabilità si ritrova nelle corde dell’accademico matematico e dell’eticista[19] quanto dello scienziato del diritto -Simoncini[20], Comandè[21] - come elemento comune che fonda la “verità” del dato, nascente dall’AI quanto di quello prodotto dall’uomo nell’esercizio delle funzioni giudiziarie. Un concetto comune capace di “giustificare” sia il dato algoritmico che quello giurisprudenziale. Un dato che è nell’essenza stessa della giustizia, ha copertura costituzionale e governa la stessa rule of law. Un dato plurale, dunque, che compare tanto nella “scienza” - che scienza non è - algoritmica che in quella matematica e giuridica e senza il quale la prima e le seconde perdono la loro stessa essenza.

Claudio Castelli ha sostenuto con forza che l’IA debba entrare nel sistema giudiziario, ma senza mai sostituire il giudice. Nella visione proposta, ispirata da una cultura delle garanzie, l’IA può aiutare a prevedere la durata dei processi, a mappare gli orientamenti delle corti, a disincentivare contenziosi pretestuosi. Ma non deve mai essere percepita come un oracolo. La discrezionalità, la personalizzazione del giudizio e l’assunzione della responsabilità sono, per Castelli, insopprimibili. E lo stesso Castelli promuove come “ricetta” per aggiornare le mappe del diritto quella della Rete fra portatori di saperi diversi- giudici avvocati ingegneri scienziati tecnici, filosofi, eticisti-. Sul concetto di fare rete si proverà a tornare nl prosieguo, apparendo centrale per affrontare il tema della “formazione”.

Da qui la centralità della formazione dei giuristi, al tempo stesso strumento idoneo a diffondere in maniera ramificata le conoscenze del nuovo, in modo da costruire nuove professionalità capaci di interagire criticamente con le tecnologie emergenti, ma anche di sfruttarne appieno le potenzialità.

Dunque, IA non come nemico del diritto né come suo destino ineludibile, ma come ricerca del discernimento che la nuova tecnologia trasformativa impone al diritto senza volerlo modificare nei suoi contenuti, semmai rendendolo coerente ad un sistema che ha un significativo bisogno tanto di efficienza che di “effettività” e che, dunque, richiede di essere disciplinato, interpretato e valutato alla luce dei princìpi fondamentali. Una prospettiva, questa, che non intende amputare la giurisdizione dal proprio ruolo di elemento pensante e portante del sistema giustizia, ma che ne fa al tempo stesso uno dei soggetti maggiormente responsabili, unitamente agli altri attori istituzionali, della tenuta della democrazia e dello Stato di diritto.

Si deve poi ad Antoine Garapon una lucida riflessione[22] sulla spasmodica ricerca, tutta del tempo presente, di una certezza “nel” diritto che, ormai impossibile da ricercare nell’ambito del tessuto normativo, si immagina finalmente possibile attraverso la sostituzione dell’algoritmo al linguaggio che “per le sue caratteristiche intrinseche, contrasta con il non spazio del calcolo”[23].

2.1. AI e verità

Sono queste le ragioni che hanno dunque portato all’affermazione di un paradigma che tende a sostituire la decisione giudiziaria, fondata sulla razionalità e sull’argomentazione, con un calcolo algoritmico basato su indicatori numerici. Questa “despazializzazione” della giustizia, osserva Garapon, trasforma il giudizio in un procedimento tecnico, strutturato in passaggi di misurazione e sistematizzazione dei dati, spesso opachi e accessibili solo agli esperti, annullando “il momento di interpretazione del diritto, che richiede a volte di rinvenire quale fosse l’intenzione del legislatore e la finalità perseguita” [24]. Il risultato è un sapere “esoterico” e poco contestabile, in cui la logica formale copre e cristallizza le premesse valoriali preesistenti che hanno dato forma all’algoritmo.

Esempi come il software COMPAS, usato in alcuni Stati USA per valutare la probabilità di recidiva, mostrano come il giudizio si riduca a un conteggio di punti pro/contro, spostando l’attenzione dalla valutazione del fatto passato alla prevenzione di rischi futuri. Questo rischia di modificare il ruolo del giudice, privilegiando competenze di risk assessment rispetto alla conoscenza giuridica, e favorendo processi di standardizzazione simili al “tipo normativo d’autore”. Più in generale, la digitalizzazione ha contribuito a una rivoluzione culturale che ha indebolito lo spazio fisico come riferimento della vita civile, marginalizzato il momento politico nella produzione normativa e spersonalizzato l’amministrazione della giustizia, esaltando la tecnica come soluzione rassicurante alle ansie sociali. Siamo dunque al tramonto della figura di giudice dubbioso, alla ricerca della soluzione adeguata al caso al termine di un percorso complicato, incerto, di ricerca della verità? L’AI risponde al dubbio finale che assillava il giurista “pre AI” – sarà “davvero vero”? - che si poneva o che si sarebbe dovuto porre - secondo Bobbio[25]? Abbiamo finalmente trovato l’antidoto, con l’uso pur accorto e magari ben addestrato dell’AI nell’ambito della giustizia, la soluzione finale rispetto alle incertezze prodotte da orientamenti ondivaghi della giurisprudenza di legittimità? Abbiamo dunque trovato il rimedio all'incerta nomofilachia con la certezza dell’AI?

Buffa, forse, ma pericolosa quest’ultima provocazione e magari bene accetta a chi con varie rime sollecita e attende l’eliminazione di quella “ambiguità” del vertice più volte stigmatizzata- anche se da altri forse molto più perspicuamente intesa- , pronto magari a cavalcare l’onda dell’AI per depotenziare la funzione giurisdizionale nella sua essenza, a ben vedere messa a repentaglio non già solo per la Cassazione, ma per l’intero sistema di tutela giurisdizionale, ormai solo apparentemente nelle mani dei giudici di merito, sempre più dominato, in realtà della predittività dell’AI.

Il discorso è estremamente delicato e tocca, al fondo, in generale il ruolo della giurisdizione[26] e, in particolare, della funzione nomofilattica della Corte di cassazione, tutto imbastito su una trama di complessità del diritto sulla quale altre volte abbiamo provato a riflettere[27] e che si pone agli antipodi di un’idea di giurisdizione affidata alla predittività artificiale, quasi che la stagione che si aprirà innanzi al futuro della società sarà e non potrà che essere quella della nomofilachia algoritmica.

Un ragionare, minato già sul nascere dalla consapevolezza che i sistemi di AI generano spesso falsi filoni giurisprudenziali che lo rendono su quel versante assolutamente poco affidabile, aprendo peraltro le porte a questioni di alta complessità in ordine ai profili di responsabilità dei soggetti che fruiscono di tali informazioni introiettandole nell’attività giudiziaria. Temi, questi ultimi, rispetto ai quali l’intera comunità dei giuristi non potrà che prospettare i rischi altissimi in termini di credibilità dei ruoli ricoperti. Una posizione, però, che sembrerebbe doversi orientare verso un'opposizione “ragionevole” a ciò che potrebbe snaturare il sistema giudiziario senza chiudersi, invece, alle opportunità di incremento dell’indipendenza che l’AI potrebbe offrire[28]. Un’opposizione netta dovrà orientarsi verso chi pensa all’AI come grimaldello capace di mettere a repentaglio l’essenza stessa della Rule of law, appunto intimamente legata all’umanità della decisione, alla spiegabilità della soluzione adottata, per l’appunto sempre e comunque sagomata in ragione della specificità del caso. Il che, ovviamente, non vuol dire affatto chiudersi nella torre d’avorio, ma semmai offrire anche alla Suprema Corte di cassazione gli strumenti che possano renderne la funzione sempre più orientata verso standard di conoscibilità ed effettività capaci di alimentare quel valore della certezza del diritto dal quale non è dato ormai più prescindere[29].

È dunque questo il contesto che si apre innanzi a chi istituzionalmente ha il compito di “formare” i magistrati su tematiche, come già accennato, variamente conosciute, variamente utilizzate e variamente considerate come utili, pericolose, dannose per il futuro stesso del sistema giustizia. Una responsabilità ancora più elevata se si considera il tema dell’immagine e della forma assunta dalla giurisdizione a seconda del “modello” di AI che si intende ammettere e giustificare.

3. Formazione del giurista nell’era dell’intelligenza artificiale. Un nuovo alfabeto fra contenuti innovativi e modelli di formazione giudiziaria.

L'integrazione dell'intelligenza artificiale nel sistema giuridico non è più una prospettiva futura, ma una necessità avvertita come presente.

Tuttavia, perché questa transizione sia effettiva e rispettosa dei valori fondamentali dello Stato di diritto, il giurista deve dotarsi di nuovi strumenti, sia concettuali che pratici, aprendosi ad una serie di sfide.

Tra questa, la prima, particolarmente rilevante guardando al settore giustizia, è quella del “divario generazionale”. Scrive Violante[30]: “While the digital world often remains inaccessible to older generations, digital technology is often misused by younger generations. Education, however, can help seniors learn basic digital skills and teach young people to use digital technology responsibly”. Questo, peraltro, non significa orientare gli sforzi verso la creazione di una nuova professionalità di giudice informatico, ma semplicemente diffondere un nuovo alfabeto in modo da rendere il giurista capace di dialogare con l'intelligenza artificiale senza subirla.

Pochi sono fin qui i contributi sul “come” organizzare questa formazione che, occorre chiarire fin dall’inizio, coinvolge i fenomeni della digitalizzazione e quelli dell’AI in una prospettiva di complementarità che, tuttavia, occorre tenere ben distinti.

La digitalizzazione consiste nella trasformazione delle procedure e degli atti in formato digitale, con strumenti come il fascicolo telematico, le notifiche elettroniche o le banche dati giurisprudenziali. Tema che, particolarmente approfondito ormai da tempo sul piano interno, ha notevole impatto sulle relazioni fra ordinamenti nazionali diversi e che è orientato a realizzare un’efficiente organizzazione del lavoro senza incidere sulla funzione di giudicare.

L’intelligenza artificiale, invece, non si limita a gestire dati, ma li interpreta e li elabora attraverso algoritmi capaci di influenzare il processo nel quale si forma la decisione giudiziaria, secondo gradi e forme variabili che giungono ai sistemi di giustizia predittiva e coinvolgono i software di valutazione del rischio.

Sul primo versante, quello della digitalizzazione, la complessità sul piano formativo è forse più limitata per due ordini di ragioni. Per un verso, infatti, ci si muove su territori prevalentemente normati a livello legislativo – interno e di diritto UE - o regolamentati attraverso strumenti nazionali o sovranazionali. E sul campo la diffusione di tali conoscenze è già in atto spedita, progressiva e costante[31].

Decisamente diverso appare il discorso sull’IA.

La diversità nasce dall’assenza, a monte, di un quadro normativo definito sul tema dell’AI e sulle regole di approccio relative al come, con chi e con quali scansioni temporali organizzare la formazione dei magistrati.

Questa incertezza si riscontra nel testo del d.d.l. italiano sull’intelligenza artificiale - S. 1146 "Disposizioni e deleghe al Governo in materia di intelligenza artificiale" - approvato in seconda lettura al Senato il 25 giugno 2025 e al vaglio della Camera.

Rileva, per quel che qui interessa, l’art.14, c.4, a cui tenore “Il Ministro della giustizia, nell'elaborazione delle linee programmatiche sulla formazione dei magistrati di cui all'articolo 12, comma 1, lettera a), del decreto legislativo 30 gennaio 2006, n. 26, promuove attività didattiche sul tema dell'intelligenza artificiale e sugli impieghi dei sistemi di intelligenza artificiale nell'attività giudiziaria, finalizzate alla formazione digitale di base e avanzata, all'acquisizione e alla condivisione di competenze digitali, nonché alla sensibilizzazione sui benefici e rischi, anche nel quadro regolatorio di cui ai commi 2 e 3 del presente articolo. Per le medesime finalità di cui al primo periodo, il Ministro cura altresì la formazione del personale amministrativo.”

Il testo normativo in discussione ha, responsabilmente, cura di distinguere la formazione dei magistrati da quella del personale amministrativo. Quanto alla prima, che qui ha più rilievo, usa il verbo promuovere.

Basta scorrere il vocabolario Treccani per cogliere le diverse, ma comunque affini, portate di senso del sostantivo “promozione” qui attribuito al Ministero della Giustizia, comprese fra il far avanzare, far progredire ed il favorire, dare impulso o più semplicemente proporre, dare l’avvio, dare l’inizio, ma anche sollecitare, spingere, stimolare, fare in modo che qualcosa aumenti d’intensità.

Il riferimento normativo, interno al ricordato art.14, c.4, all’art.12, c.1 lett. a) del d.lgs. n.26/2006 sta, del resto, a significare che la SSM ha piena autonomia nell’individuazione della programmazione didattica, ma al contempo elabora la propria proposta “tenendo conto delle linee programmatiche sulla formazione pervenute dal Consiglio superiore della magistratura e dal Ministro della giustizia”. Una sinergia ed una cooperazione che negli anni si sono rivelate assai fruttuose, muovendosi sul crinale, bidirezionale, dell’autonomia e della collaborazione.

Ma il punto è, come già detto, che il testo del d.d.l. IA non è ancora legge e, dunque, che le Linee programmatiche sull’IA 2024 del CSM hanno soltanto sfiorato il tema, dichiarando espressamente che “L'utilizzo dei sistemi di intelligenza artificiale come strumento di supporto l'argomento dell'uso del lavoro del settore giudiziario merita un approfondimento, seppure si trovi tuttora in uno stato di sviluppo embrionale.” -pag.9-.

Nello stesso documento “Si suggerisce la creazione di cicli formativi sull'Intelligenza Artificiale nei vari settori dell'ordinamento e, in particolare, sull'I.A. nell'organizzazione giudiziaria e nel lavoro giudiziario, con il coinvolgimento del Consiglio Superiore della Magistratura e della CEPEJ. Si aggiunge, poi, che il possibile percorso formativo dedicato all'Introduzione all'Intelligenza Artificiale dovrebbe mirare a “fornire una base di conoscenza sui principi cardini dell'intelligenza artificiale (IA) e sulle sue applicazioni pratiche in contesti pubblici e privati, al fine di promuovere sessioni di interlocuzione critiche e informate sulle opportunità e rischi offerti dall'utilizzo di tali tecnologie”. Si suggerisce l'adozione della seguente ripartizione di argomenti 1. Introduzione all'intelligenza artificiale: esposizione dei concetti base dell'intelligenza artificiale, dei principali algoritmi e tecnologie; 2. Linee guida nazionali dell'IA e applicazioni quotidiane: rappresentazione della strategia nazionale per l'intelligenza artificiale e delle ulteriori linee guida di indirizzo. Analisi delle principali applicazioni nel mondo pubblico e privato; 3. Etica nell'utilizzo dell'IA: esplorazione dei possibili problemi di carattere etico dell'IA (es. bias nei dati), con esposizione e discussione su casi pratici”.

Sembra dunque opportuno indirizzare i progetti formativi a:

- far comprendere la natura degli algoritmi. Il giurista va aiutato a distinguere tra sistemi deterministici, che operano secondo logiche trasparenti e sistemi adattivi, che apprendono dai dati. Questa consapevolezza è cruciale per valutare la spiegabilità e l'affidabilità di una tecnologia.

- pretendere trasparenza e auditabilità dai sistemi utilizzati in ambito giudiziario. Ogni sistema adottato dovrebbe essere soggetto a controllo e spiegazione, riducendo l'opacità algoritmica ed offrendo al giurista gli strumenti per compiere le operazioni di verifica e comprensibilità dei sistemi algoritmici.

- mantenere la centralità del giudizio umano. Anche quando l'IA riuscisse a suggerire una decisione, la scelta ultima e la motivazione giuridica dovrebbero rimanere umane, non potendo il giurista accettare passivamente l'esito di un algoritmo, né delegare le sue funzioni alla macchina e, dunque, diventare ad essa subalterno, attivandosi per la spiegabilità della decisione.

Si tratta di aspetti che riflettono le preoccupazioni, già sopra esposte dalla dottrina e di recente esteriorizzate nel Rapporto dell’Agenzia europea per i diritti fondamentali (FRA) del 2025[32] e nelle opinioni nn.3 e 6 del 14 dicembre 2020[33], ove sono stati segnalati i rischi sistemici legati alla necessità di garantire un accesso effettivo e consapevole alla giustizia rispetto a controversie in cui vengono in gioco l’uso di sistemi di intelligenza artificiale, i c.d. bias algoritmici, la sorveglianza opaca, le discriminazioni di genere ed etnia, la mancata trasparenza dei processi decisionali automatizzati.

Per tale motivo la protezione dei diritti non può essere rinviata a una verifica a posteriori degli effetti prodotti dalla tecnologia ma deve, piuttosto, essere coessenziale allo sviluppo degli strumenti digitali. Occorre dunque esaminare le principali risposte normative e istituzionali anche a livello sovranazionale, volte a garantire il rispetto dello Stato di diritto anche nell’ambiente digitale e alla luce della giurisprudenza della Corte europea dei diritti dell’uomo.

4. La formazione del giurista nell’era dell’intelligenza artificiale

Secondo un sondaggio esposto da un docente inglese ad un corso organizzato dalla SSM per i giovani magistrati europei da poco concluso a Castel Capuano, nel Regno Unito il 73% dei magistrati non usa l’AI nella sua attività ma…il 27% sì!

Si tratta di un dato sul quale riflettere al fine di garantire, da parte della formazione, standard di conoscenza capaci di salvaguardare il canone dell’eguaglianza in favore dell’utenza.

Se la trasformazione digitale e l’ingresso pervasivo dell’intelligenza artificiale nei processi sociali, amministrativi e giurisdizionali pongono interrogativi radicali sul ruolo e sulle competenze del giurista contemporaneo, occorre affrontare consapevolmente questa transizione e dunque “progettare” un modello formativo che, nella cornice delle linee fondamentali già esposte, risponda in modo articolato a tre domande fondamentali: 1.che cosa deve sapere un giurista sull’IA e su quali contenuti vada orientata la formazione[34]; 2. come deve essere formato;3. con quali partner collaborare alla sua formazione.

Questo modello si innesta in modo coerente con l’attuale struttura della formazione dei magistrati italiani, articolata sul piano interno in una formazione (iniziale e permanente) centrale, gestita dalla Scuola Superiore della Magistratura con il fondamentale supporto della formazione decentrata, attraverso i formatori distrettuali[35]. La sinergia tra questi livelli consentirebbe di declinare un’offerta formativa sull’IA che sia allo stesso tempo unitaria nei principi e adattabile alle specificità locali in termini numerici e logistici, capace di combinare teoria e pratica, innovazione e salvaguardia dei valori costituzionali. Il tutto creando vitale e continua sinergia fra le strutture decentrate ed i magistrati MAGRIF-Magistrato di Riferimento per l’Innovazione e l’Informatica- statutariamente chiamati ad intercettare le necessità dell’ufficio giudiziario in tema di informatizzazione, innovazione tecnologica e ad elaborare proposte in collaborazione con i RID (Referenti distrettuali per l’innovazione) e con la dirigenza dei singoli uffici anche per individuare buone prassi.

Ma anche su questo versante è necessario che il progetto formativo offra ai formatori decentrati opportunità di crescita sul piano delle conoscenze in tema di AI e, dunque, investa sul piano della formazione dei formatori in maniera specifica, anche attraverso l’organizzazione di attività formative specifiche (corso HELP, di cui si dirà appresso) direttamente orientate a “formare” chi è chiamato ad organizzare progetti formativi su scale distrettuale.

Sul piano internazionale, per converso, la SSM partecipa con grande dinamismo alla Rete di formazione europea dei magistrati, al cui interno è stato di recente istituito un settore specificamente dedicato alla digitalizzazione della giustizia ed è partner di numerosi progetti internazionali con altre scuole di magistratura e istituzioni universitarie impegnate a vario titolo nella formazione dei magistrati. Luoghi, questi ultimi, nei quali il tema dell’AI è sempre più al centro delle attività di formazione.

I progetti finanziati dalla Commissione europea ai quali ha partecipato con successo la SSM- progetti EnJita 3, Split e Trust AI- possono infatti rafforzare la dimensione comparata e sovranazionale dei contenuti formativi sull’IA, favorendo un allineamento tra standard nazionali ed europei in ambito etico, giuridico e tecnologico e lavorando ancora una volta con un’ottica improntata a “fare rete” in una direzione rivolta a condividere esperienze.

Il giurista nostrano dovrebbe per questo essere messo in condizione di formarsi in prospettiva comparata e globale, per cogliere le dinamiche transnazionali dell’IA e del diritto. In questa prospettiva andrebbe sviluppata la comparazione tra modelli normativi all’avanguardia in materia: USA, Cina[36], Europa (capostipite sul tema della tutela dei diritti fondamentali).

Accanto a questa prospettiva è necessario approfondire gli standard etici e la conoscenza delle linee guida in materia (Commissione Europea, CEPEJ, Consiglio d’Europa).

A titolo meramente esemplificativo, può qui ricordarsi la banca dati Resource Centre on Cyberjustice and AI della CEPEJ[37], ove sono documentati i sistemi di intelligenza artificiale e gli strumenti digitali già utilizzati o in fase di sviluppo nei diversi ordinamenti giudiziari europei, descrivendone caratteristiche tecniche, ambiti di applicazione, soggetti responsabili e stato di avanzamento. La sua utilità per la formazione sembra evidente se si guarda alla possibilità di offrire ai magistrati e agli operatori della giustizia una visione comparata e aggiornata delle tecnologie applicate alla giurisdizione, distinguendo tra esperienze consolidate e sperimentali, in modo da favorire un apprendimento in progress e comparato. Ciò nella prospettiva di assimilazione, da parte dei magistrati, di un complesso intreccio di trasformazioni che non li veda passivi fruitori di sistemi non pienamente conosciuti, ma invece protagonisti principali, capaci di valutare rischi e opportunità dei vari sistemi e promuovere lo scambio di esperienze.

Per altro verso, l’European Cyberjustice Network[38], istituito sempre dalla CEPEJ nel 2021, conferma ancora una volta la necessità di fare rete, non potendosi affrontare la trasformazione digitale della giustizia con una prospettiva domestica. Favorendo lo scambio di esperienze, la circolazione di buone pratiche e il confronto con partner istituzionali e accademici di altri Paesi, l’ECN conferma come solo attraverso la cooperazione multilivello improntata a fiducia reciproca sia possibile sviluppare strumenti realmente efficaci, legittimi e coerenti con i principi comuni dello Stato di diritto. Una formazione dedicata anche alle piattaforme e reti appena ricordate e sviluppate all’interno del CEPEJ si dimostra allora fondamentale per la preparazione del giurista, consentendo non solo di conoscere le tecnologie più avanzate applicate alla giustizia, ma anche di comprendere i contesti europei in cui esse si sviluppano, le reti di cooperazione che ne favoriscono la diffusione e i principi comuni che ne orientano l’uso. Una formazione così non solo tecnica, ma invece capace di far maturare una consapevolezza comparata e multilivello, indispensabile a chi esercita funzioni giurisdizionali in un sistema sempre più interconnesso.

Né di minore valenza appare la “Carta etica europea sull’utilizzo dell’intelligenza artificiale nei sistemi giudiziari e negli ambiti connessi”, adottata dalla CEPEJ nel 2018, ove il giudice è posto al centro del rapporto tra giurisdizione e innovazione tecnologica. Se è indubbio che gli strumenti di IA possano contribuire ad accrescere efficienza e qualità, “è essenziale assicurare che essi non minino le garanzie del diritto di accesso a un giudice e del diritto a un equo processo [...] Essi dovrebbero essere utilizzati anche con il dovuto rispetto per i principi dello stato di diritto e dell’indipendenza dei giudici nel loro processo decisionale” (p. 8).

Questa centralità del giudiziario si riflette anche nell’uso quotidiano delle tecnologie, visto che secondo la Carta “i professionisti della giustizia dovrebbero essere in grado, in qualsiasi momento, di rivedere le decisioni giudiziarie e i dati utilizzati per produrre un risultato e continuare ad avere la possibilità di non essere necessariamente vincolati a esso alla luce delle caratteristiche specifiche di tale caso concreto” (p. 13). Affinché il controllo giudiziario sia effettivo occorre, dunque, un’adeguata formazione, per cui “dovrebbero essere previsti programmi di alfabetizzazione informatica, destinati agli utilizzatori, e dibattiti che coinvolgano i professionisti della giustizia” (p. 13).

Sono queste le ragioni per cui nella Carta etica del 2018 si sottolinea che, lungi dall’essere un mero strumento di efficienza, l’IA deve “rafforzare le garanzie dello stato di diritto, nonché la qualità della giustizia pubblica” (p. 15), in un quadro in cui il giudice resta il garante supremo dei diritti e l’IA un supporto subordinato al rispetto della rule of law.

Proprio in questa prospettiva di respiro non ridotto al piano nazionale, assumono particolare rilevanza le strategie di diffusione della cultura dei diritti fondamentali all’interno del progetto HELP costituito presso il Consiglio d’Europa.

Un esempio significativo di networking formativo è appunto rappresentato dal corso HELP su Intelligenza Artificiale e Diritti Fondamentali, sviluppato dal Consiglio d’Europa[39]. Importare ed utilizzare, con i necessari adattamenti, tale corso nel sistema di formazione giudiziaria italiano significa predisporre un percorso che, pur mantenendo il format generale HELP, sia calibrato sulle esigenze concrete dei magistrati italiani. Questo adattamento non è soltanto contenutistico, ma anche metodologico, poiché la previsione della nomina di un tutor appositamente scelto consente infatti di accompagnare i partecipanti, guidandoli nell’applicazione pratica dei principi e degli strumenti appresi, attraverso un percorso misto, nel quale la struttura generale del corso Help viene arricchita in relazione alla specifica realtà dei partecipanti nazionali.

In tal modo, lo sviluppo in materia di formazione giudiziaria a livello europeo può e deve trovare un punto di raccordo con il sistema nazionale, garantendo non solo il trasferimento di conoscenze, ma anche la loro effettiva integrazione nel contesto giuridico interno.

Ecco, quindi, la “rete” nella quale la SSM potrebbe e dovrebbe giocare un ruolo di rilievo per la magistratura e per il Paese.

4.1. L’albero della formazione dei magistrati in tema di AI: a) che cosa dovrebbe sapere un giurista?

Ricapitolando e provando a seguire il ragionamento logico che sta alla base di un ideale albero della formazione sull’AI[40], il giurista/magistrato dovrebbe poter acquisire conoscenze su diversi assi tematici, distribuiti tra formazione iniziale e permanente centrale e livello distrettuale.

Quanto alla formazione curata in sede centrale andrebbero sviluppati i seguenti temi:1) quadro normativo di riferimento[41], etica[42] e diritti fondamentali: rischi per l’autonomia decisionale, non discriminazione algoritmica, privacy, trasparenza, controllo umano;2) sistemi di AI e loro comprensione; 3) logica giuridica versus logica computazionale[43]: differenze epistemologiche, limiti della giustizia predittiva, ambiguità e valori;4) modelli comparati e linee guida internazionali. Tali temi andrebbero poi restituiti a livello di formazione decentrata- in sinergia con MAGRIF e RID-, lasciando alle singole formazioni decentrate l’autonomia sull’approfondimento di singoli aspetti affrontati a livello centrale e soprattutto le fasi laboratoriali tese a favorire lo sviluppo e l’apprendimento pratico delle nuove tecnologie, degli strumenti e delle pratiche operative, anche per verificare i rischi dell’uso dell’AI, i bias sistemici e le buone pratiche di uso dell’IA.

Il tutto per rafforzare la cultura dei diritti nel contesto digitale e fornire ai magistrati strumenti critici per valutare la compatibilità costituzionale e convenzionale dell’impiego dell’AI, in una prospettiva di bilanciamento tra innovazione e tutela della persona.

Seguendo questo percorso, la formazione sul piano delle fonti passerà poi, necessariamente, per la verifica dell’integrazione fra fonti sovranazionali e nazionali in materia dovendosi verificare, appena sarà varato in via definitiva il testo normativo interno sull’AI, in che misura gli spazi regolati sul piano domestico si pongano in armonia o in discontinuità con i parametri europei, rappresentati non solo dai Regolamenti citati, ma anche dalla Carta dei diritti fondamentali dell’UE.

La formazione andrebbe dunque pensata come un percorso ibrido, esperienziale e progressivo.

Un primo livello -centrale- dovrebbe privilegiare eventi con una didattica integrata e workshop orientati a sviluppare tematiche di taglio etico-normativo, prevedendo eventualmente delle restituzioni a livello decentrato, previa individuazione delle strutture formative capaci di indirizzarsi ad un numero rilevante di magistrati, investite del compito di predisporre, con piena autonomia, i iniziative di restituzione/ripetizione di corsi organizzati a livello centrale, con modulazioni eventualmente peculiari in relazione alle singole realtà territoriali. Il naturale dinamismo che caratterizza le formazioni distrettuali potrebbe così fare rete con le iniziative centrali, sperimentando laboratori pratici, simulazioni processuali con strumenti di IA e riflessioni condivise sull’impatto effettivo dei sistemi nei vari settori della giurisdizione.

Questi due livelli andrebbero realizzati con una didattica integrata che combini teoria, casi studio, laboratori e simulazioni, affiancando un sistema di monitoraggio e valutazione continuativa per verificare l’applicazione delle conoscenze a problemi complessi anche a distanza dai seminari organizzati.

Il sistema di rilevazione utilizzato in ambito EJTN, basato su piattaforme interattive come Mentimeter, potrebbe (e forse dovrebbe) essere agevolmente esportato presso la Scuola Superiore della Magistratura anche per i corsi dedicati all’intelligenza artificiale.

Tale strumento sembra prestarsi in modo equilibrato[44] a testare il grado di conoscenza di nozioni tecniche rispetto alle quali la maggior parte dei magistrati non possiede una formazione di base, consentendo di effettuare una misurazione oggettiva delle competenze iniziali e finali dei partecipanti. Attraverso un questionario somministrato in apertura e in chiusura del corso, composto da domande a risposta multipla o quiz strutturati sugli argomenti trattati, è possibile rilevare da parte degli esperti e relatori in tempo reale il livello di apprendimento, visualizzare i dati in forma aggregata durante la sessione e successivamente esportarli per elaborazioni statistiche che, oltre a calcolare l’incremento medio delle conoscenze, includono la rilevazione delle percentuali di risposte corrette e non corrette sia nel pre-test che nel post-test. L’analisi dei feedback raccolti offrirebbe alla Scuola superiore un patrimonio informativo prezioso per calibrare l’offerta futura e per orientarla in modo sempre più aderente alle esigenze reali della giurisdizione, in coerenza con il suo ruolo di presidio della rule of law. Infatti, in termini più generali, la misurazione dell’offerta formativa deve rappresentare un punto cruciale, poiché un sistema di valutazione quanto più accurato consente di verificare non solo la qualità metodologica e contenutistica dei programmi, ma anche la loro capacità di incidere realmente sulle competenze dei magistrati. La misurazione diventa allora uno strumento per rendere la formazione accountable, pienamente responsabile rispetto agli obiettivi di tutela dei diritti fondamentali e di rafforzamento delle garanzie dello Stato di diritto.

4.2. Segue: b) con chi dovrebbe essere formato il magistrato?

Anche su questo aspetto il modello da seguire dovrebbe procedere con il sistema della rete integrata, in modo da coinvolgere a diversi livelli, giuristi- giudici, avvocati, notai- informatici, filosofi ed eticisti da affiancare ad esperti del settore tecnologico (ingegneri, sviluppatori, data scientist).

A queste professionalità, come già accennato, andrebbero affiancati altri attori istituzionali e regolatori (CSM, Ministero Giustizia, Garante Privacy, Commissione Europea, Ordini professionali, Osservatori della giustizia, OCSCE) insieme agli enti strategici nazionali come -Agenzia per la Cybersicurezza Nazionale (ACN) e l'Agenzia per l'Italia Digitale (AgID), con cui sarebbe fondamentale, sulla scia delle prospettive tratteggiate da Castelli, avviare collaborazioni periodiche per integrare nei percorsi formativi comuni temi legati alla sicurezza informatica, alla protezione dei dati, all'interoperabilità dei sistemi e alla qualità dei servizi digitali pubblici, in un'ottica di sinergia tra innovazione tecnologica e tutela giuridica[45].

5. Conclusioni (in progress)

La Convenzione quadro del Consiglio d’Europa del 2024 sopra richiamata afferma che l’uso dell’IA deve restare pienamente coerente con i diritti umani, la democrazia e lo Stato di diritto (art. 1). Per altro verso, le disposizioni su trasparenza, responsabilità, ricorsi effettivi e indipendenza giudiziaria (artt. 4–7) mostrano che senza magistrati adeguatamente formati tali principi rischiano di restare astratti. La formazione giudiziaria diventa, dunque, strumento indispensabile per rendere effettivo lo Stato di diritto di fronte alle sfide poste dall’intelligenza artificiale.

Al termine di questa riflessione sembra davvero confermata la necessità di fornire a chi si impegna nella produzione del diritto e a chi si occupa della sua applicazione gli strumenti intellettuali necessari per mantenere il controllo della situazione in fieri e utilizzare proficuamente gli apporti della intelligenza artificiale[46].

La proposta che pare possibile delineare mettendo insieme i tasselli (tanti) qui sommariamente utilizzati intende offrire una possibile prospettiva metodologica sul piano organizzativo della formazione dei magistrati in tema di AI, volta ad immaginare una vera e propria cabina di regia alimentata dai diversi protagonisti che istituzionalmente hanno a cuore il tema dell’AI nel sistema giustizia che raccolga i contributi di tutti gli attori interessati, valorizzi le esperienze già maturate anche solo in via sperimentale, attivi sinergie con organismi nazionali e sovranazionali mettendo a profitto i progetti internazionali già in corso e quelli da intraprendere, moltiplichi le opportunità di formazione anche in sinergia con l’Avvocatura[47] e favorisca una cooperazione strutturata fra livelli centrali e decentrati delle strutture di formazione della SSM.

Tutto questo in modo che possa procedersi gradualmente e progressivamente ad un sistema formativo che riguardi al contempo i formatori dei formatori ed i magistrati tutti e, in generale, il sistema Giustizia.

Lo sviluppo di un progetto formativo sull’AI dovrebbe dunque fondarsi sull’idea di “fare squadra”, pure suggerita di recente da uno dei massimi studiosi della materia anche sul piano etico[48]. Pensare di poter prescindere da queste forme di dialogo, confronto e cooperazione, interna ed esterna, preferendo fragili personalismi sarebbe al tempo stesso velleitario e scarsamente orientato ad una logica di condivisione delle problematiche molteplici che si aprono innanzi agli operatori ed a chi è chiamato a governare l’eventuale utilizzo dei sistemi di AI nel settore della giustizia.

Questo sembra essere l’(unico) orizzonte solido, al cui interno potere realizzare un luogo di dialogo e di coordinamento in grado di dare credibilità e autorevolezza ad ogni progetto di formazione sul tema che possa risultare effettivo e credibile.

In questo modo la formazione giudiziaria sull’intelligenza artificiale potrà svilupparsi come percorso di alto profilo, capace di coniugare innovazione tecnologica, tutela della rule of law e dei diritti fondamentali, insieme a responsabilità istituzionali degli Enti coinvolti.

Per altro verso, ogni iniziativa di formazione dei magistrati sull’intelligenza artificiale di lungo orizzonte dovrebbe potersi fondare su un quadro normativo definito e integrato che, come si è visto, allo stato è ancora non ben definito, sia quanto alle competenze che ai limiti degli strumenti di AI in ambito giudiziario.

È questo l’elemento di partenza che oggi manca sul piano nazionale, mentre a livello europeo l’orizzonte è stato segnato dal già ricordato Regolamento (UE) 2024/1689, che impone obblighi specifici per i sistemi di IA ad alto rischio. L’assenza di una cornice chiara e definita sul piano delle competenze in materia di formazione dei magistrati e, ancora prima, sulle caratteristiche dei sistemi di AI in ambito giustizia, affiancata all’assenza di una normativa di recepimento del quadro UE suggerisce, dunque, prudenza rispetto a progetti formativi di lungo respiro e, dunque ad oggi difficilmente in grado di orientare la prassi.

C’è ancora tempo, dunque, per mettere a punto una strategia cooperativa diretta ad integrare e meglio orientare le scelte di politica formativa in tema di AI, in modo che l’innovazione tecnologica sia messa al servizio del sistema giustizia e all’interno di una cornice complessiva della programmazione annuale e pluriennale.

[1] L. Violante, Human rights in the digital society, in https://www.pass.va/en/publications/studia-selecta/studia_selecta_07_pass/violante.html.

[2] L. Violante, Diritto e potere nell’era digitale. Cybersociety, cybercommunity, cyberstate, cyberspace: tredici tesi, in Biolaw Journal n.1/2022 ,145 ss.

[3] O. Pollicino, Di cosa parliamo quando parliamo di costituzionalismo digitale?”, in Quaderni Costituzionali n. 3/2023.

[4] Intervista di J. Paoletti a Oreste Pollicino, l’Intelligenza Artificiale e il rischio di un Leviatano chiamato Tecnocrazia, 29 aprile 2025, in https://www.iaic.it/news/oreste-pollicino-lintelligenza-artificiale-e-il-rischio-di-un-leviatano-chiamato-tecnocrazia/

[5] O. Pollicino, Digital Private Powers Exercising Public Functions: The Constitutional Paradox in the Digital Age and its Possible Solutions, https://www.echr.coe.int/documents/d/echr/Intervention_20210415_Pollicino_Rule_of_Law_ENG.

[6] T. Groppi, Alle frontiere dello stato costituzionale: innovazione tecnologica e intelligenza artificiale, in Consultaonline, 28 settembre 2020, 675, spec. 678 e 679.

[7] O. Pollicino, P. Dunn, Intelligenza artificiale e democrazia, Opportunità e rischi di disinformazione e discriminazione, Bocconi University, 2024.

[8] A. Simoncini, Sovranità e potere nell’era digitale, in T. E. Frosini, O. Pollicino, E. Apa, M. Bassini (a cura di), Diritti e libertà in internet, Firenze, 2017, 20.

[9] A. Simoncini, Il linguaggio dell’intelligenza artificiale e la tutela costituzionale dei diritti, in Riv.AIC, 12 aprile 2023.

[10] N. Lipari, Diritto, algoritmo, predittività, in AA.VV., Giocare con altri dadi Giustizia e predittività dell’algoritmo, a cura di V. Mastroiacovo, Torino, 2024, 4 e ss.

[11] Sul punto, v. l’approfondito saggio di S. Dorigo, L'intelligenza artificiale e i suoi usi pratici nel diritto tributario: Amministrazione finanziaria e giudici, in S. Dorigo, R. Cordero Guerra, Fiscalità dell’economia digitale, Pisa, 2022, 192 ss.

[12] G. De Minico, Giustizia e intelligenza artificiale: un equilibrio mutevole”, Rivista AIC – Rivista dell’Associazione Italiana dei Costituzionalisti, n. 2/2024.

[13] G. De Minico, Un argine è necessario e riguarda il potere politico, Il Sole 24 Ore, 12 agosto 2025

[14] G. Gallone Riserva di umanità e funzioni amministrative, Milano, 2023.

[15] Così anche R. D’Angiolella, Giustizia e intelligenza artificiale tra l’AI ACT e il disegno di legge italiano. L’insostituibilità del giudice, il metodo e l’argomentazione giuridica, in questa Rivista, 30 luglio 2025.

[16] G. Gallone. op. cit., 42.

[17] C. Castelli, Decidere con l’IA. Intelligenze artificiali e naturali nel diritto. Recensione al libro di A. Santosuosso e G. Sartori, Bologna, (Il Mulino, 2024), in Questionegiustizia. 23 maggio 2025.

[18] V., sul punto, M. Vallone, Spazio virtuale le garanzie di giurisdizione nella resilienza e nella difesa della sicurezza nazionale, Atti del convegno svolto nei giorni 11/12 ottobre 2024 in Roma, Palazzo della Farnesina, Prefazione, 14, in Quaderno della Rivista Trimestrale della Scuola di Perfezionamento per le Forze di Polizia, n.1/2025.

[19] P. Benanti, L’opacità della AI non ha precedenti, ma noi dobbiamo scrutarla, in Corrieredellasera, Sette, 18 luglio 2025. 12

[20] A. Simoncini, Il linguaggio dell’intelligenza artificiale e la tutela costituzionale dei diritti, Riv.AIC, n.2/2023, 12 aprile 2023, 31, a proposito della decisione algoritmica: La comprensibilità deve essere garantita, sia per i cittadini che per il giudice, in tutti gli aspetti: “dai suoi autori al procedimento usato per la sua elaborazione, al meccanismo di decisione, comprensivo delle priorità assegnate nella procedura valutativa e decisionale e dei dati selezionati come rilevanti” (richiamando Cons. Stato, Sez. VI, 8 aprile 2019, n. 2770 n.d.r.)

[21] G. Comandè, Intelligenza artificiale e responsabilità tra "liability" e "accountability". Il carattere trasformativo dell’IA e il problema della responsabilità, in Analisi Giuridica dell’Economia, 2019, 175 ss.

[22] A. Garapon, Le despazializzazione della giustizia, Milano, 2021.

[23] A. Garapon, La despazializzazione della giustizia, cit., 148.

[24] A. Garapon, La despazializzazione della giustizia, cit., 147.

[25] G. Zabrebelsky, Il dubbio e il dialogo. Il labirinto di Norberto Bobbio, Torino, 2024, 62.

[26] Nella Prefazione a Il ragionamento giuridico nell’era dell’intelligenza artificiale (AA.VV., a cura di S. Dorigo, Pisa 2020), il curatore del volume sottolinea come l’attività giurisdizionale non possa essere surrogata dall’automazione, poiché “l’interpretazione e l’applicazione delle norme giuridiche è da sempre un fenomeno umano: e questo perché le norme non sono mai chiare e quindi è sempre richiesto un quid pluris intellettuale per portarle ad esecuzione” -XVI-. Proprio l’ingresso dei sistemi intelligenti nei processi decisionali impone di chiarire se essi possano davvero supportare il ragionamento giuridico o se ne alterino “in modo decisivo il modo di essere” (ib.). Nello stesso volume, R. Köche, L’intelligenza artificiale a servizio della fiscalità: il sistema brasiliano di selezione doganale attraverso l’apprendimento automatico (SISAM) osserva che le decisioni della macchina non sono fondate soltanto su parametri giuridici, ma anche su criteri “politici ed economici” e che, pertanto, “la sua adeguatezza deve essere valutata sulla base di criteri di legittimità giuridica – altrimenti si supererebbero i limiti democratici” (P.340). In quest’ottica, il ruolo del giudice rimane imprescindibile: spetta a lui verificare la conformità delle scelte automatizzate ai parametri costituzionali e garantire che il controllo fiscale o amministrativo sia guidato dal rispetto della legge, “come ci si aspetta in uno Stato di Diritto” (P.342). L’autore mette in guardia, infine, rispetto all’illusione che l’intelligenza artificiale possa esaurire il compito ermeneutico: “esiste tuttavia una dimensione ermeneutica non trasponibile per l’intelligenza artificiale, una sorta di insufficienza semantica del processo decisionale” (p.342). Ne deriva che la giurisdizione non può essere ridotta a un calcolo probabilistico, e che la funzione del giudice – adeguatamente formato per comprendere opportunità e limiti degli strumenti tecnologici – resta centrale per salvaguardare il senso stesso del diritto nell’era digitale.

[27] V., volendo, R. Conti, Il mutamento del ruolo della Corte di cassazione fra unità della giurisdizione e unità delle interpretazioni, in Consultaonline, 7 dicembre 2015; id., La Corte di cassazione e la sua funzione, in questa Rivista, 17 novembre 2018; id., Nomofilachia integrata e diritto sovranazionale. I "volti" delle Corte di Cassazione a confronto, in questa Rivista, 4 marzo 2021; id., La funzione nomofilattica delle Sezioni Unite civili vista dall’interno (con uno sguardo all’esterno), in questa Rivista, 11 gennaio 2024. V., ancora, Intervista di R.Conti a R. Rordorf, G. Luccioli, E. Lupo e G. Canzio sul tema “Diritti fondamentali e doveri del giudice di legittimità, in questa Rivista, 19 giugno 2019.

[28] Cfr. V. Montani, Logica umana e applicazioni della razionalità artificiale. Intervista al Prof. Angelo Costanzo, in DIMT, https://www.dimt.it/news/logica-umana-e-applicazioni-della-razionalità-artificiale-intervista-al-prof-angelo-costanzo/: “l’utilizzo dell’intelligenza artificiale, nelle sue varie forme e graduazioni, può influire positivamente sull’imparzialità del giudicante perché può ampliare il novero dei dati e delle prospettive da utilizzare per la decisione. Ma comporta anche il rischio di frenare, inibire, deviare o cristallizzare l’immaginazione logica e l’immaginazione etica che sono le sorgenti della imparzialità, intesa nel suo senso più pregnante di apertura – emancipati da pregiudiziali autolimitazioni intellettuali − alle diverse ragionevoli interpretazioni dei dati normativi e alle diverse non implausibili ricostruzioni dei fatti… La razionalità artificiale non è in grado di sostituire il giurista ma può aiutarlo quando tratta una quantità di dati superiore a quelli che un individuo umano può gestire.”

[29] V., sul punto, G. Amoroso, Riflessioni in tema di diritto vivente e intelligenza artificiale e di D. Micheletti, Algoritmi nomofilattici a confronto: ufficio del massimario vs. intelligenza artificiale, entrambi in AA.VV., Giocare con altri dadi Giustizia e predittività dell’algoritmo, a cura di V. Mastroiacovo, Torino, 2024, rispettivamente pagg.176 e 185.

[30] L. Violante, Human rights in the digital society, cit., sub arg.n.4.

[31] Si veda, sul punto, F. Di Vizio, Il ruolo della SSM nella formazione digitale dei magistrati e le prospettive di utilizzo dell’IA nell’attività giudiziaria. Relazione all’incontro annuale del CSM con i RID, Roma, Palazzo Bachelet, 5 giugno 2025, a quanto consta, inedito.

[32] https://fra.europa.eu/sites/default/files/fra_uploads/fra-2025-fundamental-rights-report-2025_en.pdf

[33] https://fra.europa.eu/sites/default/files/fra_uploads/fra-2020-artificial-intelligence_en.pdf

[34] In questa direzione si muove, a titolo meramente esemplificativo, la struttura della Formazione presso la Corte di Cassazione, promotrice di una iniziativa, calendata per il prossimo 30 settembre, sul tema della rilevanza dell’AI sull’attività giurisdizionale di merito e di legittimità- Gli strumenti dell'intelligenza artificiale e l'attività giudiziaria, in https: //www.cortedicassazione.it/page/it/gli_strumenti_dellintelligenza_artificiale_e_lattivita_giudiziaria?contentId=EVN46203.

[35] L’esperienza dimostra che proprio dalle sedi decentrate si siano sviluppate esperienze poi proiettate ed ampliata alla dimensione nazionale. Di recente, la formazione decentrata presso la Corte di appello di Cagliari ha organizzato un corso su Diritto e neuroscienze -31 marzo 2 aprile 2025, per cui v. il sito della SSM, parte materiali multimediali -. Tra queste, quella in corso a Catania sull’uso dell’intelligenza artificiale in ambito giudiziario si fonda su una serie di progetti sperimentali che vedono coinvolti diversi partner istituzionali. In tale contesto il Tribunale di Catania ha avviato con il Consorzio Interuniversitario Nazionale per l’Informatica (CINI) una sperimentazione rivolta alla sezione civile-imprese, con l’obiettivo di applicare strumenti di analisi automatica e classificazione degli atti-v. B. L. Mazzei, Tribunale di Catania e Consorzio Cini per l’uso dell’AI nella giustizia, in Ilsole24ore, 26 maggio 2025, in https://www.ilsole24ore.com/art/tribunale-catania-e-consorzio-cini-l-uso-dell-ia-giustizia-AHCr05u?refresh_ce-. Parallelamente l’Università di Catania, insieme a diverse facoltà, partecipa al progetto nazionale del Ministero della Giustizia JUST-SMART, finalizzato a sviluppare modelli e strumenti digitali per migliorare l’organizzazione del lavoro giudiziario, la calendarizzazione delle udienze ed il monitoraggio dei carichi-v. https://www.giustizia.it/giustizia/page/it/upp_dettaglio_macroarea_6#-. Ancora una volta, alla base di queste esperienze c’è l’idea di fare rete per costruire un solido scambio di esperienze tra tribunali, università e centri di ricerca, orientati in modo cooperativo ad integrare innovazione ed esigenze di migliore efficienza del sistema giudiziario, in coerenza con la rule of law.

[36] V. L. Violante, Diritto e potere nell’era digitale. Cybersociety, cybercommunity, cyberstate, cyberspace: tredici tesi, cit.: “Un esempio di Cyberstate è la Cina, il cui modello dovrebbe essere analizzato per individuare i rischi che la democrazia corre nel Cyberspace. Nel 2017 il Governo cinese ha pubblicato il “Piano di sviluppo dell'IA di nuova generazione per il 2030”, finalizzato ad assumere la leadership mondiale nel campo dell’AI entro il 2030. In questo documento, il governo cinese affermava che conquistare la posizione leader nella tecnologia dell’IA era fondamentale per affermare la posizione militare ed economica della Cina nel mondo. L’obiettivo, esposto nel documento, è incorporare nell'IA tutti gli aspetti della vita privata e pubblica, dell'industria, del commercio, della difesa e della sicurezza. La Cina ha usato l’AI per la competizione globale facendo leva soprattutto sull’enorme quantità di dati che i cittadini cinesi generano sia online che offline, alla luce del fatto che la società cinese si basa su Internet e sull’uso del cellulare per qualunque transazione, sia per acquisti online sia per dati offline come semplici pagamenti. Il Piano AI identificava 7 aree chiave dell’IA su cui la Cina intendeva esprimere la propria leadership: a) Sistemi di imaging medica per la diagnosi precoce di malattie; b)Intelligenza audio per il riconoscimento vocale; c) Veicoli intelligenti in grado di navigare autonomamente in scenari complessi; d) Traduzione linguistica in scenari multilingua; e) Robot di servizio in grado di sostituire gli esseri umani in settori come l'istruzione, l'assistenza e la pulizia; f) Veicoli aerei senza pilota; g) Riconoscimento delle immagini, comprensione e sintesi di video, con ricerca di immagini specifiche all'interno di un video e l'integrazione uomo-video. La Cina ha impegnato centinaia di miliardi di dollari per il successo di questo piano. I risultati conseguiti: n. 1 al mondo per numero di papers di ricerca e di documenti sull'IA più citati in tutto il mondo; n. 1 al mondo nei brevetti AI; n. 1 al mondo negli investimenti di capitale di rischio dell'IA; n. 2 al mondo per numero di aziende di intelligenza artificiale; n. 2 al mondo per più grande pool di tali enti. Nel 2021, un rapporto della Stanford University indica che i ricercatori cinesi di intelligenza artificiale vengono citati più di tutti gli altri.”

[37] https://www.coe.int/en/web/cepej/resource-centre-on-cyberjustice-and-ai.

[38] https://www.coe.int/en/web/cepej/european-cyberjustice-network.

[39] https://rm.coe.int/artifical-intelligence-course-brief-english/1680b0cfe8

[40] Non è inutile, rispetto alla prospettiva offerta nel paragrafo, il riferimento all’albero di Porfirio operato da A. Costanzo, Dal pre-conscio al diritto artificiale, in questa Rivista, 10 febbraio 2023.

[41] Sui primi aspetti rassegnati nel testo, particolare attenzione andrebbe riservata al Regolamento europeo sull’intelligenza artificiale (AI Act), che ha introdotto obblighi di impatto sui diritti fondamentali per i sistemi ad alto rischio e al Digital Services Act (DSA), relativo ai doveri delle piattaforme nella rimozione dei contenuti illeciti. Centrale appare, poi, l’analisi della legislazione europea (e della relativa giurisprudenza della Corte di Giustizia UE) sulla disciplina dei dati personali e del loro utilizzo da parte dell’autorità giudiziaria nell’ambito dell’attività decisoria. Particolare attenzione andrebbe poi riservata alla Convenzione quadro del Consiglio d’Europa sull’intelligenza artificiale, i diritti umani, la democrazia e lo Stato di diritto, adottata il 17 maggio 2024 e firmata, a nome dell’Unione Europea, in base alla Decisione (UE) 2024/2218 del Consiglio. Tale Convenzione, prima nel suo genere, si propone come una piattaforma di base contenente un complesso di garanzie minime ed impone che ogni applicazione dell’AI rispetti criteri di trasparenza, tracciabilità, partecipazione, rimedi effettivi e supervisione umana, riaffermando che anche nel contesto tecnologico valgono le garanzie dello Stato di diritto.

[42] L’approfondimento sul piano etico e deontologico che riguarda l’approccio del giudiziario all’AI dovrebbe costituire un ulteriore momento di approfondimento, coinvolgendo l’autogoverno della magistratura (CSM) in una prospettiva volta a stimolare un quadro rispettoso dei diritti fondamentali in campo.

[43] A. Costanzo, Dal pre-conscio al diritto artificiale, cit.

[44] Sembra infatti complesso immaginare, allo stato, forme sicuramente più sofisticate di rilevazione della concreta efficacia dell’attività formativa sui partecipanti, tenuto conto del numero di incontri di formazione organizzati e dell’organizzazione dei seminari anche all’interno del sito della SSM. Sul punto il contenuto del Quaderno n.12 della SSM, Ten years of the Italian School for the Judiciary (2011-2021), in https://ssm-italia.eu/wp-content/uploads/2022/12/Ten-years-of-the-Italian-School-for-theJudiciary.pdf?utm_source=chatgpt.com

[45] Proprio la fluidità di questo scenario spiega l’interesse del volume Assessing the Impact of Artificial Intelligence Systems on Fundamental Rights, che si misura sul terreno ancora in movimento della necessità di garantire un controllo adeguato sui sistemi di IA ad alto rischio. Gli autori non si limitano a sottolineare l’urgenza della questione, ma elaborano una proposta concreta, il FRIAct, vale a dire un modello di Fundamental Rights Impact Assessment concepito per tradurre in pratica le prescrizioni dell’AI Act. Come viene precisato nel volume, «The study is grounded in the obligations set forth by Regulation (EU) 2024/1689, known as the Artificial Intelligence Act (AI Act), which emphasises the necessity of assessing and mitigating risks to fundamental rights», e il FRIAct «is a critical tool mandated by the AI Act for certain high-risk AI systems». Non si tratta, dunque, di un mero esercizio teorico, ma di un tentativo di dare attuazione concreta a un obbligo giuridico, colmando la distanza tra principi costituzionali e operatività quotidiana. Il meccanismo proposto si fonda su una duplice struttura: da un lato, un Questionario qualitativo che raccoglie informazioni sul contesto e sugli obiettivi del sistema di IA, sulle popolazioni interessate e sulle possibili implicazioni etiche e sociali; dall’altro, una Matrix capace di tradurre questi elementi in indicatori semi-quantitativi, valutando l’impatto in termini di gravità e probabilità di violazione dei diritti fondamentali. L’esito è la produzione di FRIAct Scores, utili per orientare gli enti e gli operatori che intendono utilizzare l’IA, consentendo loro di anticipare rischi e adottare adeguate misure di mitigazione. Trasferito nel settore giustizia, un simile schema mette in luce una duplice prospettiva di lavoro. Da una parte, è evidente che non si può parlare di formazione dei magistrati senza avere alle spalle una base normativa chiara e multilivello, che integri fonti interne e sovranazionali e che garantisca la coerenza delle prassi. Dall’altra, diventa indispensabile affiancare ai percorsi formativi momenti stabili di confronto, aperti a istituzioni europee, autorità regolatorie, enti nazionali e internazionali, associazioni e università: solo così la formazione dei magistrati potrà crescere non come iniziativa isolata, ma come processo condiviso e integrato.

[46] A. Costanzo, Dal pre-conscio al diritto artificiale , cit.

[47] Importanti le prospettive tracciate dal Presidente dell’Ordine degli Avvocati di Milano- A. La Lumia, AI. La UE ha anche bisogno di tecnologie, Ilsole24ore, 22 agosto 2025-.

[48] P. Benanti, L’opacità della AI non ha precedenti, ma noi dobbiamo scrutarla, cit.

Le opinioni espresse sono personali e non impegnano l'Istituzione di appartenenza.

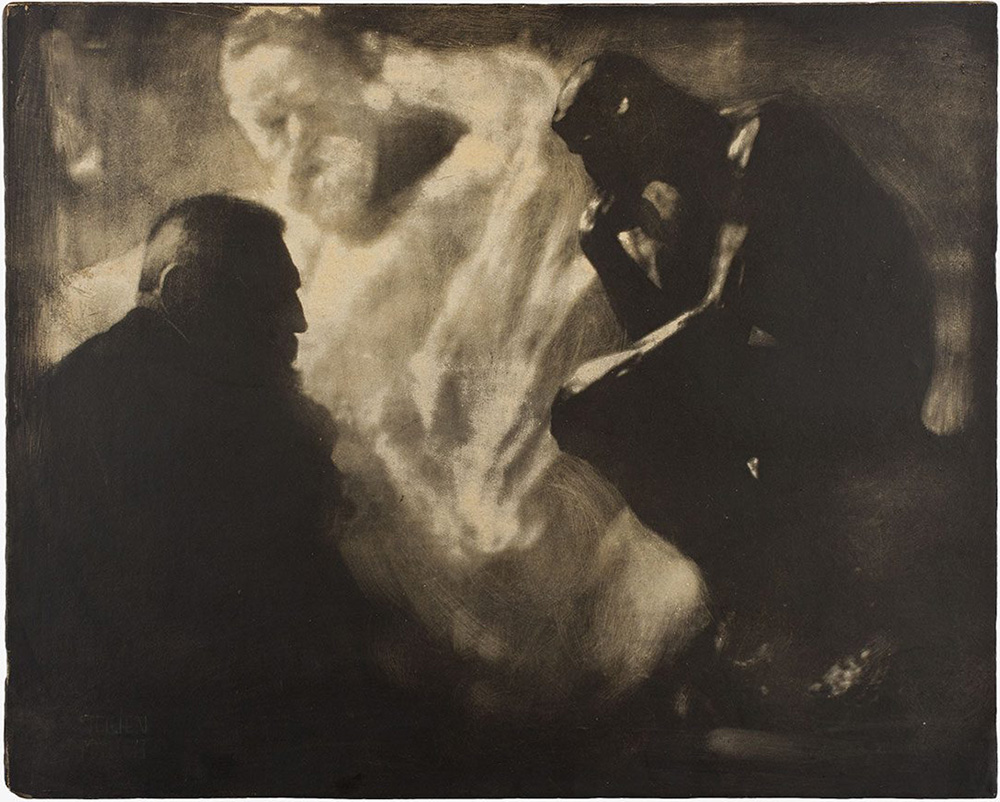

Immagine: Edward Steichen, Rodin, Il Pensiero, 1902, stampa da due negativi.

And then Add to Home Screen.

And then Add to Home Screen.